前回からの続編です。

https://www.t4dano.com/gpt-oss/

前回の記事

筆者のmac

Macbook pro 2023(late) 16インチ

cpu M3max

mem 128GB

sto 2TB

俗に言うのもりもりMacですかね。あんまりメモリとか使ったことないのでswapが0です。ひどい話、

実行

ollamaで

ollama pull gpt-oss:120bを実行。大体65GBくらいで、30分くらいで終わります。そしたら、

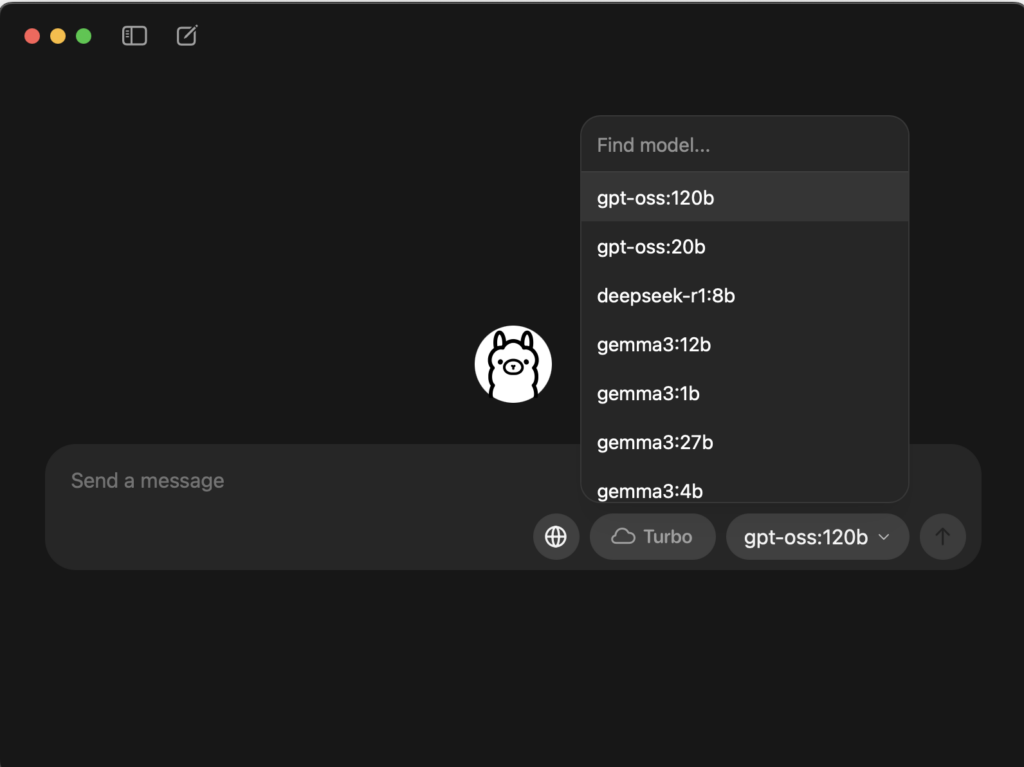

彼を立ち上げて、

120Bを選択したら。実行できます。質問してあげましょう。

負荷について

試しに、20bと120bに同じ内容について、10000文字書いていただきました。

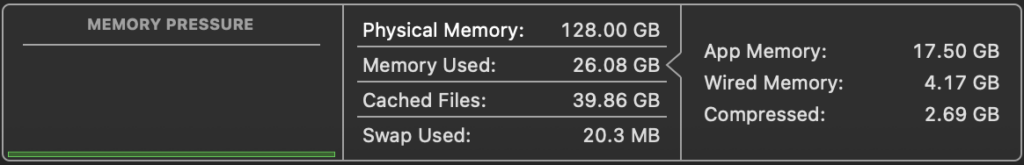

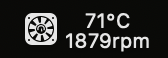

・開始時

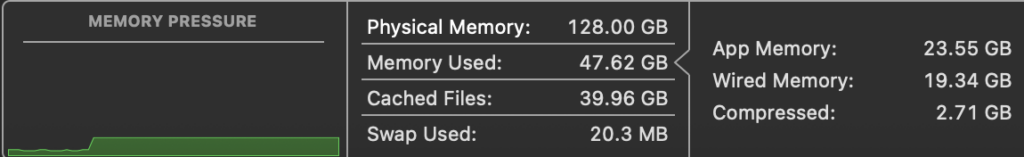

・20B

えびについて10000文字書かせたときの負荷です。

だいたい60℃くらいまで行きました。でもその間でも作業は可能なくらいの負荷。

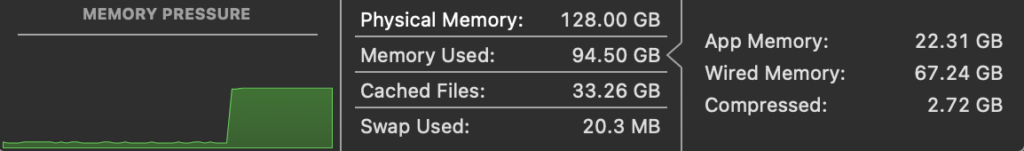

・120B

おなじ内容での実行です。wiredが3倍くらいになってます。負荷も3倍かなぁ。

あとGPUはどちらも100%張り付きでございます。

あちいね!!!!

体感的にはそこまで生成速度に差はないように思います。やっぱメモリにある程度余裕があると、決めるのはGPUらしい。今回は多分GPUがボトルネックになってるんだと思う。

てゆうかANEを使えるようにとかならないのかしら、せっかく専用チップを積んでるのにもったいない感じがすごい。

まとめ

実用的な速度はでます。でも軽さと頭の良さで考えたら20bで十分かもしれないよね〜

やっぱり据え置きでやるべきですね。明らかにmacbookではやらないべき、やけどしそう。

にしても自分のPCにChatGPTがあるって考えたらちょっとロマンかもしれませんね、試してみる価値はあります。改めてですが、画像生成などには対応しておりませんのでご注意ください。

いじょー

コメント