新しくOpenAiから出たローカル環境でchatGPTを実行できるgpt-ossをmacに入れてみましょうというお話。適当だし適当なので参考程度にしてくだしあ。

gpt-ossとは

昨日くらいになんか出てたchatgptローカルで実行できますよってやつ。画像生成とか、soraとかは使えない、テキストだけのやつ。詳しくは→

公式からご確認くださいな。

導入してみましょう

導入するには以下のステップを踏みます。

STEP1

ollamaをインストール

mac版(ARM), win, linux, →https://ollama.com/download

開いたらいい感じにいますね。。

STEP2

モデル選択(20B or 120B)しましょう。120Bはゲロ重です。

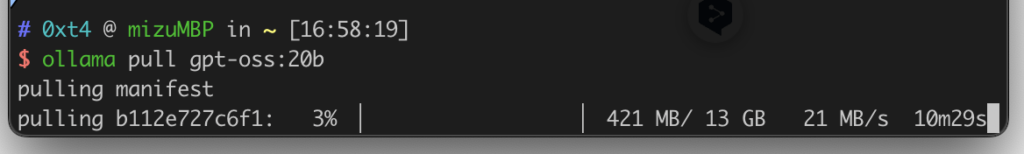

# まずは20B

ollama pull gpt-oss:20b

# 余力があれば120B(時間・容量に余裕を)

ollama pull gpt-oss:120bですね。

すると

こうなります。自動でmanifestします。

(ちなみにTerminalはIterm2使っております)

STEP3

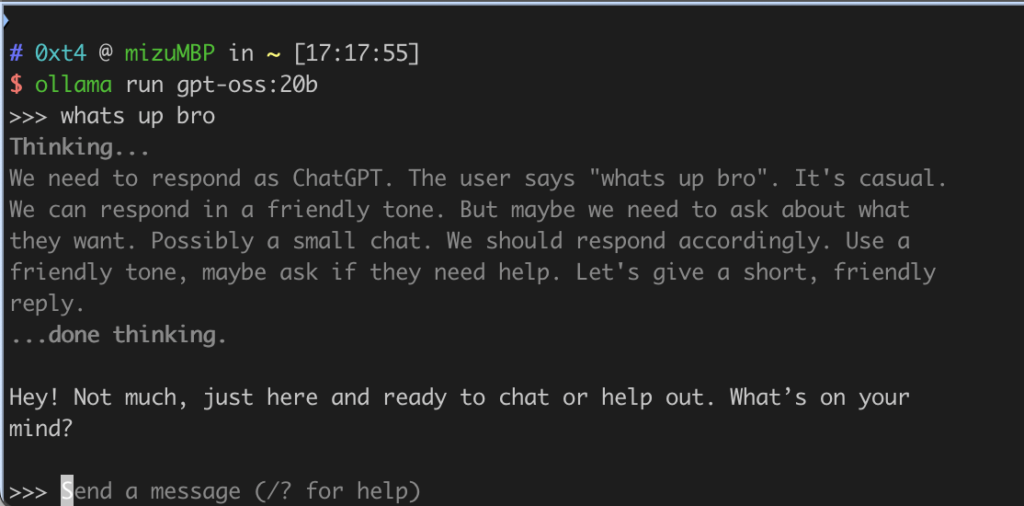

実行してあげましょう

ollama run gpt-oss:20bこれで対話は可能になりました

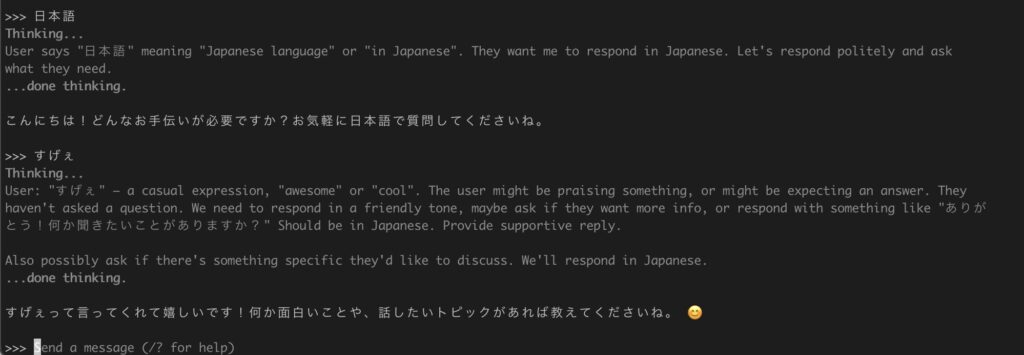

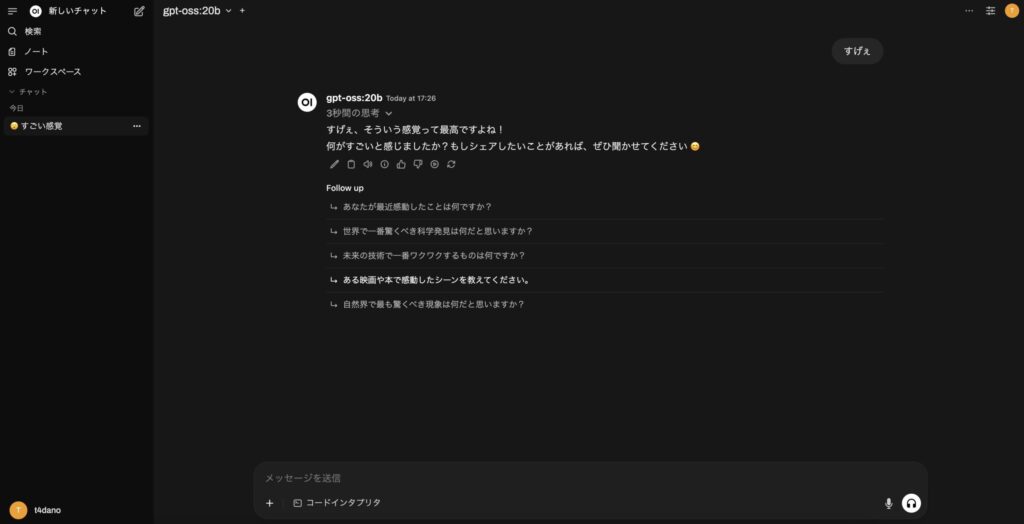

ossでは原則見れない思考の中身がユーザーに見れるようになっています。

日本語に対応しています。便利ー

止めるときは

ollama stop gpt-oss:20b消すときは

ollama rm gpt-oss:20bOPTION

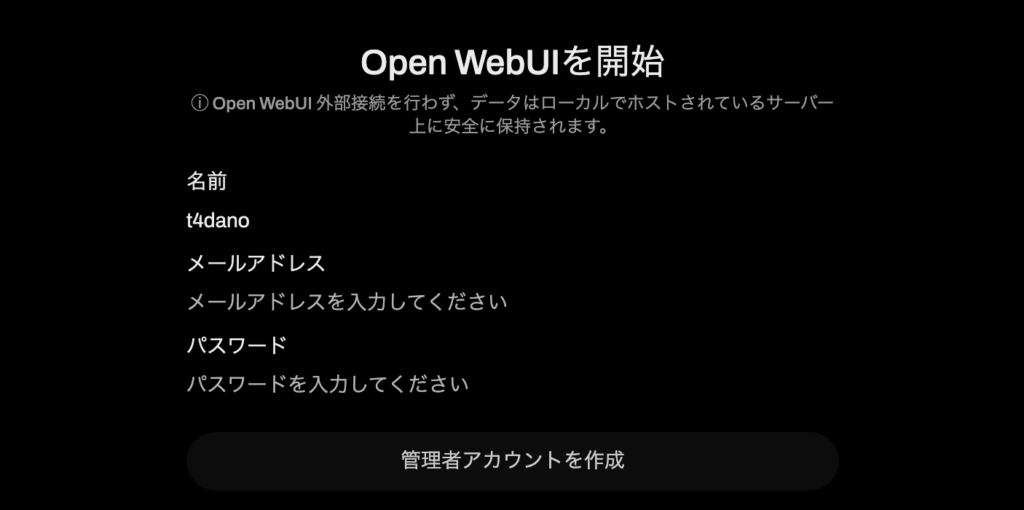

見にくいからUIがいいなぁ。こう思った人に捧げます。

open-webUIをdockerで起動するのです

docker run -d --name open-webui \

-p 3000:8080 \

--add-host=host.docker.internal:host-gateway \

-e OLLAMA_BASE_URL=http://host.docker.internal:11434 \

-v open-webui:/app/backend/data \

--restart always \

ghcr.io/open-webui/open-webui:mainこれ貼っつけて、http://localhost:3000 にアクセスするだけ。docker必須です。

そうすると

が出てくるので、登録してあげると

chatGPTのようなUIで実行可能です。

閉じるときはコンテナを止めてね。ollamaもstopのコマンドを打ってあげてね。いじょー

まとめ

面白いね。画像認識とかできないけど、噂ではo3-mini(20B), o4-mini(120B)レベルの性能が出てるらしい。コーディングとかする人ならあっても損はないかもねこれ。でも結構重たい感じするから、macbookproとかじゃなくてmac miniとか据え置きでやったほうが合理的かも。

追記

https://www.t4dano.com/gpt-oss-2/

120Bも試しました。

コメント